آیا هوش مصنوعی در دستگاه با منابع محدود قابل اجرا است؟

تا چند سال پیش فراگیری و امکان استفاده مستقیم از عامل های هوش مصنوعی در دستگاه های با توان پردازشی و ذخیره سازی پایین (در مقایسه با کامپیوتر ها) به نظر سخت می آمد.

و این چیزی بود که زمان نشان می داد در آینده نه چندان دور چه چیزی در انتظار ماست. الان که در حال مطالعه این مقاله هستیم برای همه ثابت شده که به لطف ظهور و گسترش تکنولوژی های متعدد در دسترس عموم – کامپیوتر های تک بردی(Single Board Computers) مانند رزبری پای، جتسون نانو و …، فریمورک های هوش مصنوعی بهینه شده با هدف ایجاد و اجرای مدل های هوش مصنوعی سبک از لحاظ نیاز به منابع پردازشی بصورت محدود مانند تنسورفلو لایت(Tensor Flow-Lite)، الگوریتم ها و مدل های هوش مصنوعی بهینه شده با قابلیت سازگاری و اجرای سریع تر.- دیگر هر شخص علاقه مند به این حوزه می تواند نه تنها پروژه های با هدف یادگیری یا توسعه را انجام دهد بلکه می تواند مسائل دنیای واقعی را نیز با این ابزار ها حل کند.

سوالی که همیشه ذهن علاقه مندان را به خود مشغول میکند این است که هوش مصنوعی در سطحی که ما ازش صحبت میکنیم واقعا چه پتانسیلی دارد و تا چه اندازه جدی هست و می تواند مسائل واقعی را حل کند؟!

فکر میکنم اگر کسی چنین سوالی دارد حق دارد جوابی درخور دغدغه اش دریافت کند که آن هم شاید این باشد:

بدون اینکه واردش بشویم و انجامش ندهیم نمی توانیم متوجه شویم که تا چه اندازه می توانیم جلو برویم و یا اینکه این ابزار ها تا کجا میتوانند ما را یاری کنند بدون اینکه در مقطعی از برآورده کردن نیاز هایمان عاجز بمانند.

در این میان من هم سوالی دارم اینکه: برای شروع استفاده از مزایای بی شمار هوش مصنوعی در دستگاه های با توان پردازشی کمتر – دستگاه های امبد و کامپیوتر های تک بردی – آیا باید تسلط بالایی در هر دو داشته باشیم؟ همانطور که شما هم حدس می زنید این سوال نمی تواند جواب واحد و قطعی داشته باشد. اما از آنجایی که این حوزه یک حوزه میان رشته ای محسوب می شود شاید بشود گفت که دانش نسبی از هر دو تا جایی که این دو حوزه را به یکدیگر مرتبط میکند، کافی خواهد بود.

امیدوارم که بی ربط ندانید اگر بگویم هدف من در این مقاله نه آموزش جداگانه این مباحث – که یقینا از عهده اش برآمدن برایم غیرممکن است چرا که حد و مرزی فراتر از دانش من را میخواهد- بلکه نشان دادن امکان ربط دادن این ها بصورت عملی و قابل یادگیری بدون چیز های اضافه و انجام دادنشان در خانه و پشت سیستم خودتان است.

به یاد دارم چند سال پیش قرار بود یک پروژه بینایی کامپیوتر را روی رزبری پای انجام بدهم در حالی که به برد رزبری پای دسترسی نداشتم اما از آنجایی که میدانستم چطور میشود کاری را که روی کامپیوتر با منابع و سیستم عامل و منطق متفاوت انجام داده ام را با ابزار و تغییرات مناسب روی رزبری پای اجرا کرد پس از عهدش براومدم.

ممکن است افراد دیگری مانند من باشند که به همه منابع دسترسی نداشته باشند پس سعی خواهم کرد تمام چیزهایی را که قصد دارم در مقالات آینده بیاورم قابل انجام و اجرا روی کامپیوتر خودتان باشند.

این کار از یک جهت دیگر هم مفید خواهد بود:

ما انسان ها وقتی مثال هایی از یک موضوع گسترده رو میبینیم خیلی سریع سعی میکنیم ربطش دهیم به ایده ها و سوالاتی که در ذهنمان داریم به این صورت که اگر فلان مثال قابل انجام بوده پس ایده من هم به احتمال زیاد قابل اجرا خواهد بود. یا برعکس: طبق آن مثال ایده من چندان هم عملی به نظر نمیرسد.- که البته این بن بست به معنای مطلق اش نیست بلکه به این معناست که چطور میشود این بن بست را از بین برد.

با این اوصاف میشود این نتیجه را گرفت درحالی که مخاطب نهایی صحبتهای مان همه نیست ، در حال پرنور کردن ایده های همه است.

ابزار های مورد نیاز

ابزارهایی که به آن ها نیاز خواهیم داشت شامل:

یک کامپیوتر با گرافیک 4090 و 32 گیگ رم برای آموزش و اجرای مدل های هوش مصنوعی

- خواننده: من همچین سیستمی ندارم پس بیخیال.

البته اگه من به شخصه همچین سیستمی داشتم احتمالا آدمی شاد تری بودم ولی خب ندارم.

یک کامپیوتر معمولی معمولی هم کافی هست.

زبان برنامه نویسی(پایتون)

چرا پایتون؟ این رو به عهده خودتون میزارم که جوابش رو پیدا کنید.

کتابخانه های پایتون مورد نیاز برای پروژه ها.

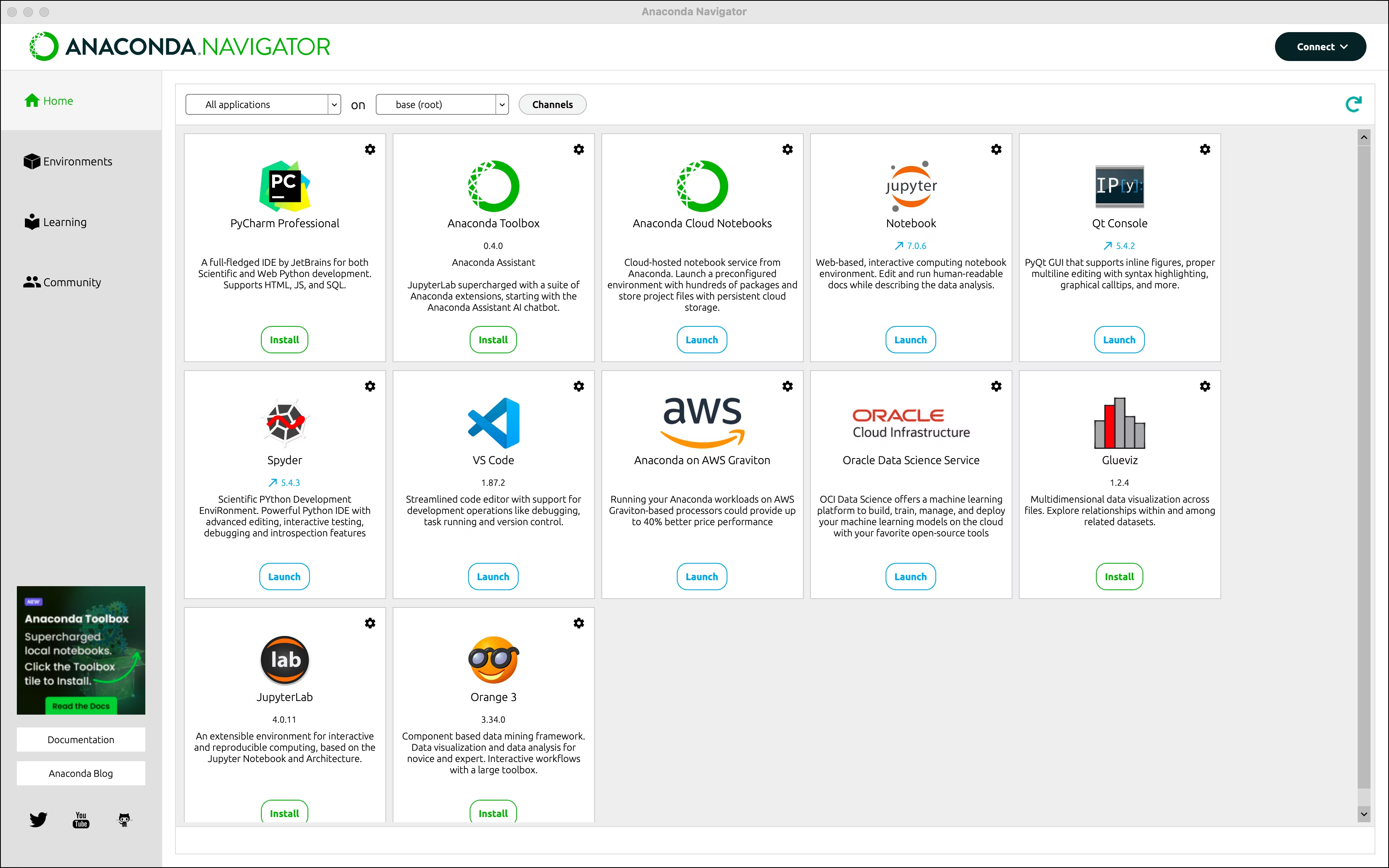

نرم افزار جامع(آناکوندا-Anaconda) که دو مورد بالا رو تماما داخل خودش دارد به علاوه چند ابزار به درد بخور دیگر.

دیتا های مورد نیاز: که نگران نباشید اینترنت پر از دیتا های بدرد بخور هست.

اما

اگر شما یک آشنا به یا متخصص الکترونیک هستید و مدام به این فکر میکنید که چطور میشود بطور مستقیم هوش مصنوعی را روی دستگاه های مختلف اجرا کرد.

یا

اگر شما علاقمند به هوش مصنوعی هستید و به این فکر میکنید که چطور میتوان هوش مصنوعی را در سطح سخت افزار و سنسور ها و عملگر ها استفاده کرد.

یا

اگر شما کسی هستید که از هر کدام کمی میداند – که من هم در این دسته قرار میگیرم- و میخواهد این دو را کنار هم قرار دهد و چیزهای جدید یاد بگیرد.

پس در جای درست در زمان درستی هستید.

دعوت میکنم مقاله بینایی کامپیوتر در هوش مصنوعی رو مطالعه کنید اگر براتون جذاب بود نظرتان را بنویسید.میتوانیم اولین پروژه را مرتبط با این موضوع کار کنیم. چطوره؟

🔗 بینایی کامپیوتر در هوش مصنوعی

💬 دیدگاهتان را بنویسید؛ شاید پروژه بعدی از ایده شما شروع شود.

سیسوگ با افتخار فضایی برای اشتراک گذاری دانش شماست. برای ما مقاله بنویسید.